Zero Trust und die Geschichte des Least PrivilegeWechsel des Sicherheitsparadigmas

26. Mai 2021

Unternehmen haben realisiert, das im Zeitalter der Cloud die herkömmliche Netzwerksicherheit zu kurz greift. Daher gilt Zero Trust als das neue Sicherheitsparadigma.

Nicht nur Applikationen haben den abgesicherten Perimeter verlassen, sondern auch die Mitarbeiter arbeiten heute von überall aus. Dabei benötigen sie den performanten und sicheren Zugriff auf ihre Anwendungen für den Arbeitsalltag und sichere Cloud-Umgebungen. Um modernen Sicherheitsanforderungen gerecht zu werden, wurde das Prinzip des Least Privilege wieder ausgegraben. Denn die Grundlage von Zero Trust ist alles andere als ein neues Phänomen.

Um dem modernen Stichwort der Sicherheitstechnologie auf den Grund zu gehen und die die Verwirrung um die Begrifflichkeit von Zero Trust aufzulösen, muss weit in der IT-Geschichte zurückgeblättert werden. Was das Konzept von Zero Trust zum Ausdruck bringen soll ist ein Startpunkt bei Null, von dem aus Berechtigungen für den Zugriff auf ein System definiert werden.

Dieser Start deckt sich mit dem altbewährten Prinzip des Least Privilege, bei dem nur Zugriff zu Informationen und Ressourcen eingeräumt wird, für die ein legitimer Zweck besteht. Die dahinterliegende Idee geht davon aus, dass niemandem ein Grundvertrauen entgegengebracht werden kann und alles in Frage gestellt werden muss, bevor schrittweise Berechtigungen eingeräumt werden können, die kontinuierlich zu validieren sind.

Im Grunde genommen verbirgt sich hinter Zero Trust also der Versuch, dem Bestreben nach einem Minimalprinzip der Zugriffsberechtigung gerecht zu werden, so wie es bereits bei frühen Unix-Systemen der Fall war. In der ursprünglichen Verwendung bedeutet der Ausdruck des Least Privilege im Computing, dass einem Anwender eine Rolle und eine Verantwortlichkeit zugeschrieben wurde, für deren Ausführung er berechtigt war.

Nach dem Login in ein System konnte damit genau ein Befehl ausgeführt werden und damit bestand somit eine auf ein Minimum limitierte Zugriffsberechtigung. Ursprünglich beruhte diese Limitierung der Möglichkeiten auf der Tatsache, dass Computing-Ressourcen rar und teuer waren. Es musste demnach sorgsam mit der Vergabe von Zugriffsrechten verfahren werden, damit die Kosten nicht durch unbegrenzten Zugriff auf ein System aus dem Ruder laufen konnten.

Verlagerung der Zugriffskontrollfunktion

Im Lauf der letzten 30 Jahre veränderte sich die Ressourcenallokation durch den Fortschritt der Technologie erheblich. Zuerst kamen neben den Großrechnern die Personal Computer in Mode. Anwender erhielten zunehmend mehr Rechte auf ihrem zunächst persönlichen Rechnersystem. Die Ausweitung der Möglichkeiten entstand durch das Aufkommen der Verbindung von PC-Systemen über das klassische Netzwerk im Unternehmen.

Nach und nach erhielt der PC mehr Funktionalität über die Verarbeitung einzelner Dokumente oder Email-Anbindung hinaus und schließlich wurde der Informationsaustausch innerhalb eines Netzwerks ermöglicht. Im Lauf der letzten Dekaden verlagerte sich der Datenverkehr darüber hinaus sukzessive aus dem Netzwerk ins Internet. Durch das Aufkommen der Cloud sind heute bis zu 90 Prozent der Datenströme von den Geräten der Anwender für das Internet bestimmt.

Im Zuge dieses Fortschritts veränderte sich die Vergabe der Zugriffsrechte und deren Kontrollfunktion, weswegen das Prinzip des Least Privilege aus der Mode kam. Die Umsetzung des Least Privilege auf einem einzelnen Gerät ist nämlich relativ einfach, da sich alles, vom Nutzer über den Prozess bis zur Kontrollfunktion, auf einem Host abspielt. Zero Trust aber wird dann komplex, wenn der Perimeter des Geräts erweitert wird, wie durch die Einbindung in ein Netzwerk, weil darauf dieses Konzept ebenfalls angewendet werden muss.

Einen Exkurs unternahm die Idee des Least Privilege zwischenzeitlich durch Network Access Control (NAC), wobei hier ein gewisses Maß an Vertrauen vorausgesetzt wurde. Dagegen wird beim Zero Trust-Ansatz kein Vertrauensvorschuss gewährt. NAC gestaltet sich allerdings als komplex und dennoch limitiert. Die Komplexität resultiert dabei aus der Kontrollfunktion, weil Geräte-Identität und Software am Client in einem Netzwerklevel isoliert behandelt werden. Allerdings bleibt das Gerät immer auf das Netzwerk angewiesen, mit dem es verbunden ist, woraus sich die Limitierung ergibt. Verlässt ein Gerät das Netzwerk, funktioniert die NAC-Kontrollfunktion nicht mehr.

Mit dem Aufkommen des Firmennetzwerks wurden also neue Sicherheitsfunktionen eingesetzt. Da die Verwaltung der Anwendungen auf deren Betrieb innerhalb eines Netzwerks begrenzt war, wurde dementsprechend ein abgesicherter Perimeter um das Firmennetz errichtet, um Angriffe von außen an der Netzwerkgrenze zu blockieren und den Zugriff zu reglementieren. Schließlich galt es sicherzustellen, dass nur berechtigte Anwender Zugriff auf bestimmte Bereiche des Netzes erhielten.

Die herkömmlichen Firewalls und Intrusion Prevention Systeme hatten demnach für eine Segmentierung des Netzwerks Sorge zu tragen. Allerdings stieg die Komplexität der Kontrollfunktion innerhalb eines Netzwerks mit wachsender Zahl von Anwendungen und Usern und mit dem zunehmenden Datenverkehr zu public und private Cloud-Anbietern.

Gleichzeitig gerieten Unternehmen durch die Ausrichtung der Datenströme in Richtung Internet und die steigende Cloudifizierung ins Visier neuer Angriffsmethoden durch professionalisierte Cyber-Kriminalität. Ein Upgrade der Hardware-Sicherheitsstapel am Perimeter fand statt, weil das klassische Gateway zum Internet zusätzlich durch Sandboxen, Inhaltsfilterung, dem Verhindern von Datenverlust sowie Informationsanalyse und -einsicht (über SIEM-Systeme) gesichert werden musste. Dennoch haben Targeted Attacks über Phishing und Ransomware Hochkonjunktur und erreichen immer wieder ihr Ziel, denn Unternehmensnetze vergrößerten durch die zunehmende Öffnung zum Internet meist unbewusst auch ihre Angriffsfläche.

Das Revival des Least Privilege

Haben Angreifer einmal die Hürde der Sicherheitslösungen am Unternehmensperimeter geknackt, besteht meist leichtes Spiel durch laterale Bewegung innerhalb des Netzwerks zu sensiblen Informationen und Systemen zu gelangen. In flachen Netzwerkhierarchien stellt die vorhandene Segmentierung meist keinen ausreichenden Schutzmechanismus dar. Als Antwort auf diese unzufriedenstellende Sicherheitslage wurde das Konzept des Least Privilege in Form von Zero Trust wiederbelebt.

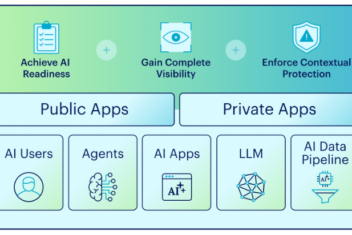

Die Idee, einen minimalen Zugangsweg vom Anwender zu seiner Applikation herzustellen, ohne dabei das Netzwerk zu benötigen, ist angesichts der Sicherheitsherausforderungen vielversprechend. Denn mit Hilfe des Least Privilege-Ansatzes gilt es nicht mehr den Zugang zum Netzwerk abzusichern, sondern eine umfassende Grundlage für ein neues Connectivity- und Sicherheitskonzept zu schaffen. Das geschieht durch das Zusammenspiel von Identifikationstechnologie und Kontrollmechanismen und funktioniert übergreifend für Anwender und Entities im gesamten modernen Konstrukt aus Multicloud- und internem Rechenzentrumsarchitekturen.

Die Idee dahinter ist ebenso einfach wie zu Beginn der Geschichte des Least Privilege. Mit Hilfe von Zero Trust lassen sich die Zugriffsrechte auf Anwendungen oder Workloads granular auf Ebene des einzelnen Anwenders und seiner benötigten Anwendungen einrichten, unabhängig davon, ob diese im Rechenzentrum oder in Multicloud-Umgebungen vorgehalten werden. Zu Beginn startet der User beim ZTNA ohne Zugriffsrechte.

Diese Rechte werden ihm nach und nach aufbauend auf seinen benötigten Anwendungen zugewiesen und mit seiner Identität verknüpft. Der Standort des einzelnen Users und der Applikation spielt in diesem Modell keine Rolle mehr, da mit Hilfe eines Cloud-basierten Zero Trust Network Access-Ansatzes auf das Netzwerk verzichtet werden kann. Die Kontrollfunktion für das Zusammenführen authentifizierter User und ihrem Zugriff auf die Anwendung findet über einen Cloud Broker Service statt, der mit Hilfe der Identität des Anwenders und unter Einbeziehung weiterer kontextbasierter Faktoren die Berechtigung kontinuierlich überwacht.

Jeder Benutzer erhält somit seinen Zugang zum Internet über einen Tunnel je Anwendung. Die klassische Art, einen Benutzer im Netzwerk anzumelden, ist daher überflüssig geworden, wodurch das administrativ intensive Konzept der Netzwerksegmentierung entfallen kann. Stattdessen wird das vorhandene Verwaltungssystem für Identitäten als Grundlage der Zugriffsrechte verwendet. Eine Sicherheitsplattform fungiert hier als Steuerung für den sicheren Tunnel der Datenströme und die Verbindung des Benutzers mit seiner Anwendung.

Zero Trust auch für Cloud-Workloads

Darüber hinaus lässt sich das Zero Trust Prinzip nicht nur auf Ebene der Anwender einsetzen, sondern ebenso zur Absicherung von Cloud-Workloads verwenden. Hier gilt ebenso die Grundlage, dass das Vertrauen in interne und externe Multicloud-Netzwerke nicht vorausgesetzt werden sollte und vor jedem Zugang eine Verifizierung erfolgen muss bevor die Kommunikation untereinander auf Basis von Richtlinien erlaubt wird. Durch den identitätsbasierten Zugriff auf Anwendungen sowie Workloads können Unternehmen ihre Angriffsfläche minimieren und zeitgleich die Möglichkeit für Cyberangreifer reduzieren, sich innerhalb des Netzwerks zu bewegen.

Das Least Privilege-Prinzip wurde im Lauf der Zeit modifiziert und an unterschiedliche Anwendungsbereiche angepasst. Zero Trust kann heute als natürliche Evolution der ursprünglichen Idee des minimalen Zugriffs betrachtet werden. Allerdings geht es heute mit der Skalierbarkeit einher, die für die Sicherheit moderner Multicloud-Umgebungen erforderlich ist.

Nathan Howe ist Vice President Emerging Technologies bei Zscaler.