Bot Traffic Report 2016 untersucht 16,7 Mrd. Besuche Bot-Aktivitäten nehmen deutlich zu

31. Januar 2017

Beim fünften Imperva Incapsula Bot Traffic Report handelt es sich um eine fortlaufende, statistische Untersuchung des Bot-Aufkommens. Für diesen Bericht wurden über 16,7 Milliarden Besuche auf 100.000 zufällig ausgewählten Domänen im Incapsula-Netzwerk analysiert und dabei folgende Fragen gestellt: Wie viel Website-Traffic wird durch Bots erzeugt? Wie werden bösartige Bots bei Cyberattacken eingesetzt? Welche Faktoren stehen hinter den Besuchen gutartiger Bots bei verschiedenen Websites und Diensten? Und: Welches sind die aktivsten, bösartigsten und gutartigsten Bots?

Bot-Aktivität

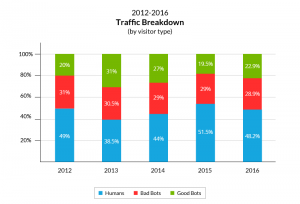

2015 ist ein Rückgang der Bot-Aktivität im Incapsula-Netzwerk dokumentiert worden. Zum ersten Mal seit Jahren fiel diese Aktivität unterhalb der 50-Prozent-Marke. 2016 wurde nun eine Umkehrung dieses Trends beobachtet. Der Bot-Traffic stieg wieder auf 51,8 Prozent und liegt damit leicht über dem Wert von 2012. Wie in der oben stehenden Grafik zu sehen, ist diese Veränderung auf eine Zunahme der Aktivität gutartiger Bots zurückzuführen. 2016 sind 504 einzelne, gutartige Bots erfasst worden, von denen 278 so aktiv waren, dass sie mindestens 1.000 tägliche Besuche im Netzwerk des Unternehmens generiert haben. Davon haben 57,2 Prozent ihre Aktivität erhöht, während nur 29,4 Prozent eine im Jahresvergleich geringere Aktivität aufwiesen.

Dies hätte zu einem stärkeren Anstieg geführt, wenn sich die meisten Änderungen (66,7 Prozent) nicht im Bereich von -0,01 bis 0,01 Prozent abgespielt hätten. Das belegt die Vorhersehbarkeit des Bot-Traffic, vor allem mit Blick auf die unterschiedliche Natur der verglichenen Proben. Dies spiegelte sich auch in den Zahlen zu den bösartigen Bots wider, deren Aktivität sich weiterhin um die 30-Prozent-Marke bewegte, wie auch in den vergangenen fünf Jahren.

Hier ist zu erwähnen, dass die relative Anzahl der Besuche bösartiger Bots (sowie der Bot-Besuche allgemein) bei weniger frequentierten Websites höher ist. So lag bei den am wenigsten frequentierten Websites – die pro Tag von maximal zehn menschlichen Besuchern aufgesucht wurden – der Anteil der bösartigen Bots bei 47,7 Prozent der Besuche, während sich der Bot-Traffic insgesamt auf 93,3 Prozent belief.

Diese überproportional hohen Zahlen sind das Ergebnis der willkürlichen Aktivität gutartiger und bösartiger Bots, wie in früheren Berichten beschrieben, auf die im letzten Abschnitt dieses Beitrags noch eingegangen wird. Einfach ausgedrückt, durchforsten gutartige Bots Websites, während bösartige Bots diese zu hacken versuchen, unabhängig von der Beliebtheit der Website bei menschlichen Besuchern. Sie besuchen sogar immer wieder Domänen, die gar keinen menschlichen Traffic aufweisen.

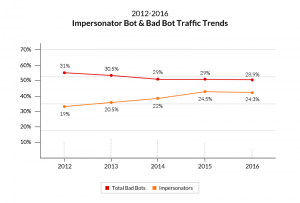

Impersonator

In der Kategorie bösartige Bots sind die Impersonators das fünfte Jahr in Folge die aktivsten Angreifer. 2016 waren sie für 24,3 Prozent des gesamten Traffic im Incapsula-Netzwerk und für 84 Prozent aller Attacken bösartiger Bots gegen Incapsula-geschützte Domänen verantwortlich. Diese unangefochtene Spitzenposition ist auf die folgenden beiden Faktoren zurückzuführen: Imitieren ist einfach und lohnt sich.

Impersonators sind Angreifer-Bots, die sich als legitime Besucher ausgeben, um Sicherheitslösungen zu umgehen. Natürlich sind solche Umgehungsfähigkeiten eine ideale Ergänzung zu allen anderen bösartigen Aktivitäten, weshalb Impersonators auch die „Waffe der Wahl“ für die Mehrzahl der automatisierten Angriffe bilden. Dies gilt vor allem, weil ein rudimentäres Maß an Verschleierung relativ einfach zu erreichen ist.

So sind die primitiveren Impersonators einfach Bots, die sich hinter einem gefälschten „Benutzeragenten“ verbergen – ein HTTP/S-Header, der die Identität des Besuchers der Anwendung mitteilt. Indem sie den Inhalt dieses Headers verändern, geben sich diese Angreifer entweder als gutartige Bots oder als Menschen aus, in der Hoffnung, dass dies genügt, um Zugang zu erlangen.

Im vergangenen Dezember wurde durch das US-Gesetz „Better Online Ticket Sales (BOTS) Act 2016“ die Verwendung von Bots zum Kauf beliebter Veranstaltungstickets unter Umgehung fairer Verkaufsregeln verboten. Die Ticket-Bots, auf die dieses Gesetz abzielen, sind ein klassisches Beispiel für Impersonator-Bots: nicht menschliche Programme, die legitime Besucher imitieren und menschliche Aufgaben automatisieren. Versiertere Angreifer gehen noch einen Schritt weiter und verändern ihre HTTP/S-Signaturen so aufwändig, dass ein browserartiges Verhalten nachgeahmt wird – darunter auch die Fähigkeit, Cookies zu erfassen und JavaScript zu parsen. Häufig tun sie beides zugleich.

Die Verschleierungsmethoden der Impersonators passen genau zu dem Ziel, das DDoS-Angreifer erreichen wollen: Einen Server mit einer hohen Anzahl scheinbar legitimer Anfragen zu überlasten. Der Server wird zum Beispiel aufgefordert, die Homepage 50.000 Mal pro Sekunde zu laden. Darin liegt ein weiterer Grund für das enorme Aktivitätsvolumen der Impersonators. Während bei einer anderen Angriffsart ein einzelner Bot-Besuch (Sitzung) ausreichen würde, muss ein DDoS-Angreifer viele Tausend Bots versenden, um sein Ziel auszuschalten.

Die aktivsten, bösartigsten Bots sind alle Impersonators, die für DDoS-Attacken eingesetzt werden. Einer davon ist die Malware Nitol, der am häufigsten auftretende, bösartige Einzel-Bot, der für 0,12 Prozent des gesamten Website-Traffic verantwortlich ist. 2016 wurde der Großteil der Nitol-Angriffe durch Impersonator-Bots gestartet, die mit älteren Versionen des Internet Explorer browsen.

Cyclone, der zweithäufigste bösartige Bot, wurde oft zur Imitation von Suchmaschinen-Crawlern verwendet, vor allem von gutartigen Google- und Baidu-Bots. Ein weiteres Beispiel ist die Malware Mirai, die vor kurzem eingesetzt wurde, um einen der bislang schwersten DDos-Angriffe zu starten. Zum Start von HTTP-Flood-Attacken eingesetzt, wendet auch Mirai Nachahmungstaktiken an, wie beispielsweise die Imitation von Chrome-Browsern. Hierbei ist anzumerken, dass die von Impersonator-Bots verwendeten Identitäten stark variieren können. So haben zum Beispiel die für diesen Bericht erfassten Nitol-Impersonators mehr als 14.000 verschiedene Varianten von Benutzeragenten sowie 17 verschiedene Identitäten verwendet.

Gutartige Bots

Gutartige Bots unterstützen die verschiedenen geschäftlichen und operativen Ziele ihrer Besitzer – von Einzelbenutzern bis hin zu internationalen Konzernen – auf vielfältige Weise. Sie lassen sich jedoch grob in die folgenden vier Gruppen einteilen:

• Feed-Fetcher – Bots, die Website-Inhalte zu Mobil- und Web-Anwendungen transportieren, die diese dann den Benutzern anzeigen.

• Suchmaschinen-Bots – Bots, die Informationen für Suchmaschinenalgorithmen sammeln, die dann für das Ranking verwendet werden.

• Kommerzielle Crawler – für autorisierte Datenextraktionen eingesetzte Spider, meist für digitales Marketing.

• Überwachungs-Bots – Bots, die die Verfügbarkeit von Websites sowie das einwandfreie Funktionieren verschiedener Online-Optionen überwachen.

Von den vier Gruppen sind dem durchschnittlichen Internetbenutzer die Suchmaschinen-Bots wohl am meisten bekannt. Sie sind jedoch nicht annähernd so aktiv wie Feed-Fetcher, auf die 12,2 Prozent des gesamten Traffic von 2016 entfielen.

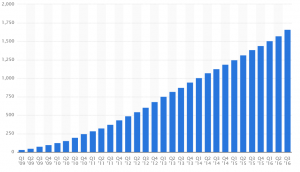

Der aktivste Feed-Fetcher – und zugleich aktivste Bot überhaupt gehört zur Mobil-App von Facebook. Er sammelt Website-Informationen, damit diese im Browser der App dargestellt werden können. Insgesamt machte er 4,4 Prozent des gesamten Website-Traffic im Incapsula-Netzwerk aus. Dies spiegelt die Zunahme der mobilen Benutzergruppe von Facebook wider, die neuen Untersuchungen zufolge im Vergleich zum Vorjahr um 19 Prozent gewachsen ist und im 3. Quartal 2016 über 1,6 Milliarden aktive Benutzer pro Monat vorweisen konnte.

Die höhere Aktivität mobiler Bots ist die Folge eines allgemeinen Trends: Die Menschen surfen immer häufiger mobil. So hat StatCounter zufolge das mobile Datenverkehrsaufkommen im November 2016 erstmals den Desktop-Datenverkehr überholt und erreichte im Folgemonat einen Anteil von 50,31 Prozent. Auch das Datenaufkommen von Imperva spiegelt diese Verlagerung wider. 2016 wurde eine Zunahme um 10,6 Prozent beim Website-Traffic durch mobile Benutzer festgestellt. Die Anzahl der Besuche durch Desktop-Benutzer ging gleichzeitig um 16 Prozent zurück. Allerdings bleiben in der erfassten Mustergruppe die Desktop-Benutzer in der Mehrzahl und machten 55,39 Prozent aller menschlichen Besuche aus.

Android-Framework, der zweitaktivste Feed-Fetcher, ist ebenfalls mit der mobilen Nutzung verknüpft, als Agent von Prozessen für Dalvik und Android Runtime. Gleiches gilt für den Bot CFNetwork, der dritthäufigste Feed-Fetcher-Bot, der in mobilen Apps für das iPhone verwendet wird. Insgesamt machen mit mobilen Apps und Diensten verknüpfte Bots mehr als 69 Prozent des gesamten Feed-Fetcher-Traffics aus, woran man die Auswirkungen der mobilen Revolution auf die Bot-Aufkommen ablesen kann.

Die alarmierendste Statistik in diesem Bericht ist zugleich auch ein konstanter Trend, der beobachtet wurde: In den letzten fünf Jahren war jeder dritte Website-Besucher ein bösartiger Bot. Die Auswirkungen dieses Trends bekommen zahlreiche Betreiber digitaler Plattformen zu spüren, von denen der Großteil regelmäßig mit nicht menschlichen Angreifern konfrontiert ist. So haben von den 100.000 in dieser Studie untersuchten Domains 94,2 Prozent in dem Studienzeitraum von 90 Tagen mindestens einen Bot-Angriff verzeichnet.

Oft sind diese Angriffe das Werk von Cyberkriminellen, die mit breit angelegten automatisierten Angriffen Tausende von Domänen zeitgleich ins Visier nehmen. Diese wahllosen Attacken sind zwar nicht annähernd so gefährlich wie zielgerichtete Angriffe, dennoch haben sie das Potenzial, zahlreiche nicht geschützte Websites zu schädigen. Ironischerweise sind es gerade die Besitzer dieser Websites, die oft die Gefahr von Bots ignorieren. Sie verzichten auf grundlegende Sicherheitsmaßnahmen, da sie fälschlicherweise meinen, zu klein zu sein, um die Aufmerksamkeit von Angreifern auf sich zu ziehen. Diese Einstellung trägt zum Erfolg von Bot-Attacken bei und ermutigt damit Cyberkriminelle, immer größere und ausgefeiltere automatisierte Angriffe zu starten.

Methodik

Die hier präsentierten Angaben beruhen auf einer Probe von über 16,7 Milliarden Besuchen durch Bots und Menschen im Zeitraum vom 9. August 2016 bis zum 6. November 2016. Die Traffic-Daten stammen von 100.000 zufällig ausgewählten Domänen im Incapsula-Netzwerk. Der Jahresvergleich wurde anhand von Daten durchgeführt, die für den vorangehenden Bot Traffic Report gesammelt wurden, also über 19 Milliarden Besuche durch Bots und Menschen in einem 90-Tage-Zeitraum vom 24. Juli 2015 bis zum 21. Oktober 2015. Die Probe wurde aus 35.000 Incapsula-geschützten Websites gesammelt, die pro Tag von mindestens zehn menschlichen Besuchern aufgesucht wurden.

Geografisch betrachtet, deckt der beobachtete Traffic alle 249 Länder der Welt, abhängige Gebiete und Gebiete von geopolitischem Interesse ab (anhand der Codes aus dem Standard ISO 3166-1). Die Analyse wurde mithilfe der Incapsula Client Classification-Engine durchgeführt. Einer proprietären Technologie, die Quervergleiche zwischen Faktoren wie HTTP-Fingerabdruck, Ursprung von IP-Adressen sowie Verhaltensmuster erlaubt, um so eingehenden Web-Traffic identifizieren und klassifizieren zu können. (rhh)

Hier geht es zu Imperva