Die Cloud im eigenen Unternehmen Der Hypervisor muss unsichtbar werden

30. Mai 2017

Wer die Verwaltungskonsolen der großen Cloud-Anbieter nutzt, bewegt sich nur noch auf der Ebene der Workloads und weist ihnen die benötigten Ressourcen zu. Ob und wie diese vorher virtualisiert wurden, spielt dabei keinerlei Rolle. Das ist Cloud Computing, wie man es als Konsument kennt und schätzt: Einfach anklicken, was man gerade braucht, ohne irgendetwas mit den dafür benötigten Ressourcen zu tun zu haben. Was für viele IT-Administratoren auf den ersten Blick vielleicht wie ein Horrorszenario klingt, ist jedoch genau das, was ihre Kollegen von ihnen erwarten: Ein Anruf bei der IT, was man gerne hätte oder dringend benötigt, ein paar Klicks und los geht’s!

Schatten-IT ade

Wer sich dem Ideal „Ein Anruf reicht und schon steht die gewünschte IT-Ressource parat“ nicht annähert, ist mit einer wachsenden Schatten-IT konfrontiert. Denn aus der Sicht der Fachabteilungen ist die Konkurrenz zur unternehmenseigenen IT im Internet nur einen Mausklick entfernt. Verbote helfen hier auf Dauer nicht weiter.

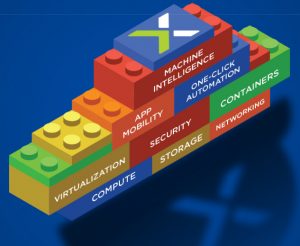

Ein Rechenzentrum, das nach Art der Cloud funktioniert, setzt freilich eine Infrastruktur voraus, die so weit wie möglich ausschließlich von Software gesteuert wird. Und dies wiederum bedeutet, dass alles, was sich virtualisieren lässt, tatsächlich virtualisiert wird. Damit wird aber gleichzeitig der Hypervisor zur Massenware, die nicht knapp und daher fast zu jedem Preis begehrt ist, sondern einfach da zu sein hat. Somit rücken die über die reine Technik hinausgehenden Aspekte bei Investitionen in die Rechenzentrums-Infrastruktur, einschließlich der Hypervisor-Umgebung, in den Mittelpunkt der Überlegungen. Dazu zählen insbesondere:

1. Verwaltbarkeit: eine Hypervisor-Umgebung muss sich problemlos verwalten lassen. Dafür braucht es ein entsprechendes Werkzeug, schließlich ist eine Lösung immer nur so gut wie seine Verwaltungskonsole.

2. Datensicherheit: um für den Einsatz in Unternehmen geeignet zu sein, muss jedes System Eigenschaften mitbringen, die Applikationen und ihre Daten schützen und im Bedarfsfall verlustfrei wiederherstellen können.

3. Hochverfügbarkeit und Ausfallsicherheit: bei geschäftskritischen Anwendungen sind Ausfälle nicht hinnehmbar. Dies gilt nicht nur für ungeplante Ausfälle wie kaputte Festplatten oder nicht antwortende Hypervisoren, sondern auch für geplante wie Wartungsarbeiten oder Upgrades.

4. Analysen zum operativen Betrieb: wie lautet der aktuelle Auslastungsgrad einer Anwendung? Werde ich als Administrator vor drohenden Problemen automatisch gewarnt? Habe ich Zugriff auf Was-wäre-wenn-Szenarien, die nicht nur meine kurzfristige Arbeit erleichtern, sondern auch meine mittel- und langfristige Planung? All diese Fragen sollten sich mit Ja beantworten lassen.

5. Leistungsdaten: eine Hypervisor-Umgebung sollte sich automatisch an Schwankungen in der Nutzung anpassen können, um unnötige Latenzzeiten schon im Vorfeld zu vermeiden. Dazu gehört zum Beispiel die automatische Verlagerung von Applikationen oder virtuellen Maschinen auf andere Ressourcen.

6. Gesamtbetriebskosten (oder neudeutsch TCO): alle zuvor genannten fünf Aspekte müssen neben dem reinen Anschaffungs- und Implementierungsaufwand bei der Betrachtung der Gesamtbetriebskosten über einen längeren Zeitraum berücksichtigt werden. Je weniger Zeit die Administratoren mit reiner Verwaltungs- und Wartungstätigkeit verbringen müssen und je höher der Automatisierungsgrad ausfällt, desto rentabler sind Investitionen in Infrastrukturlösungen, die nach dem Cloud-Computing-Prinzip aufgebaut sind und dabei die Hypervisor-Umgebung unsichtbar machen.

Alternative OpenSource?

Wenn es um IT-Investitionen geht, hat die Open-Source-Bewegung dafür gesorgt, dass bei Projektplanung nicht nur kommerzielle Lösungen, sondern auch quelloffene zum Zuge kommen. Gerade wenn Unternehmen sich den Aufwand bewusstmachen, den sie selbst oder mittels eines Dienstleisters treiben müssten, um zu vergleichbaren Aussagen hinsichtlich Funktionalitätsumfang und Betriebskosten zu gelangen, lässt sich der Wert kommerzieller Angebote besser einschätzen.

Im Hypervisor-Umfeld hat sich die quelloffene Virtualisierungsumgebung CentOS KVM etabliert. Sie bietet grundlegende Funktionen, muss jedoch um Eigenschaften wie Migration von virtuellen Maschinen im laufenden Betrieb oder Hochverfügbarkeit ergänzt werden, um im Unternehmenseinsatz konkurrenzfähig zu sein. Dabei gilt es, insbesondere die folgenden Punkte zu beachten:

1. Verwaltbarkeit: Um im Rechenzentrum à la Cloud Computing unsichtbar zu werden, braucht KVM eine Verwaltungskonsole, über die sich auch alle anderen Infrastrukturkomponenten wie Speicher oder Netzwerk administrieren lassen und die zudem ausfallsicher ist. Außerdem darf sie keine zusätzlichen Anwendungen oder Datenbanken erfordern, um die in der Konsole angezeigten Daten vorzuhalten.

2. Datensicherheit: Um Unternehmensdaten effektiv zu sichern, muss eine Virtualisierungsumgebung auf KVM-Basis mehrere Szenarien unterstützen, von der Archivierung über Sicherung und Wiederherstellung bis hin zu „Instant Recovery“, also dem prompten Zurücksetzen von virtuellen Maschinen auf einen früheren Wiederherstellungspunkt mittels regelmäßiger Snapshots. Integrationsmöglichkeiten zu spezialisierten Lösungen zur Datensicherung sind in diesem Zusammenhang ebenfalls sinnvoll und notwendig.

3. Hochverfügbarkeit: Nicht nur Rechen- und Speicherressourcen, sondern auch Virtualisierungsumgebungen müssen redundant ausgelegt sein, um einen unterbrechungsfreien Betrieb in Unternehmensrechenzentren zu gewährleisten. Die Administratoren müssen dabei die Möglichkeit haben, den virtuellen Maschinen in der Ersatzumgebung genügend Ressourcen zuzuweisen und schon im Vorfeld zu reservieren, damit diese ihre Aufgabe tatsächlich und ohne Leistungseinbußen übernehmen können. Darüber hinaus muss die Hypervisor-Umgebung weiterfunktionieren, wenn die Verbindung zu Speichermedien unterbrochen ist oder der Storage-Dienst ausfällt.

4. Analysen zum operativen Betrieb: Übersicht und Transparenz ist das, was Administratoren brauchen, um Probleme im laufenden Betrieb zu lösen oder am besten schon im Vorfeld zu vermeiden. Zusätzlich benötigen sie Analysen zu historischen Daten, um weit genug im Voraus zum Beispiel eine Erweiterung der Ressourcen planen und vorbereiten zu können. Nur so lässt sich ein Engpass oder Leistungsabfall zuverlässig vermeiden.

5. Leistungsdaten: Gewöhnlich wird Leistung anhand von Kriterien gemessen, die aus der Zeit vor den softwaregesteuerten und virtualisierten Rechenzentren stammen. Ein Beispiel hierfür wäre IOPS. Dabei bestehen gerade in virtuellen Umgebungen mit von vorneherein möglichst hohen Auslastungsgraden massive Abhängigkeiten zwischen den verschiedenen virtuellen Workloads und ihrem Ressourcenverbrauch. Änderungen an der einen Stelle rufen notgedrungen spürbare Änderungen an einer anderen hervor. Selbst für erfahrene Administratoren ist es schwierig, hier den Überblick zu behalten und manuell einzugreifen. Die nötigen Anpassungen, um die Leistung der einzelnen Workloads und des Gesamtsystems bei Änderungen aufrechtzuerhalten, müssen daher automatisiert ablaufen. Auch das muss eine Virtualisierungsumgebung können.

Unternehmenseinsatz

Der Aufwand, eine quelloffene Hypervisor-Umgebung wie KVM fit für den Unternehmenseinsatz zu machen, ist also groß. Die Unternehmen müssten beträchtliche Investitionen in deren Erweiterung und Pflege über den gesamten Lebenszyklus hinweg tätigen. Ist folglich der Widerspruch zwischen der Notwendigkeit, in einem softwaregesteuerten Rechenzentrum die Virtualisierungsebene so unsichtbar wie Rechenressourcen, Speicher und Netzwerke zu machen, und dem dafür nötigen Aufwand oder der Anschaffung passender Lösungen unauflösbar?

Um diese Frage zu beantworten, sollten Unternehmen, die ihr Rechenzentrum nach Art des Cloud Computing modernisieren wollen, bei ihren Lieferanten die oben genannten Eigenschaften einer „unsichtbaren“ Hypervisor-Umgebung einfordern und den Kreis der zu evaluierenden Anbieter in Richtung moderner, softwaregesteuerter Infrastrukturlösungen erweitern.

Hier geht es zu Nutanix

Dr. Markus Pleier

ist Director Deutschland und Österreich bei Nutanix.