Ökosystem für Anwendungen, Datenbanken und große Datenintegrationen in Delta LakeData Ingestion Network bringt die Lösung

20. März 2020

Unternehmen verfügen über eine Fülle von Informationen, die in verschiedenen Quellen gespeichert sind. Diese Daten für Business Intelligence-, Berichts- und maschinelle Lernanwendungen zusammenzuführen, ist eines der größten Hindernisse für die Ableitung von realen Geschäftswerten aus Datenanalysen. Die Datenquellen variieren von operativen Datenbanken wie Oracle, MySQL usw. bis hin zu SaaS-Anwendungen wie Salesforce, Marketo usw.

Das Einfügen all dieser Daten in ein zentrales Lakehouse ist oft schwierig und erfordert in vielen Fällen eine benutzerdefinierte Entwicklung und Dutzende von Konnektoren oder APIs, die sich im Laufe der Zeit ändern und dann den Ladeprozess der Daten unterbrechen. Viele Unternehmen verwenden unterschiedliche Datenintegrations-Tools, die von den Data Engineers das Schreiben von Skripten und die Planung von Aufträgen, die Planung von Triggern und die Behandlung von Auftragsausfällen erfordern. Letztlich kann diese Vorgehensweise nicht skalieren und verursacht einen massiven betrieblichen Aufwand.

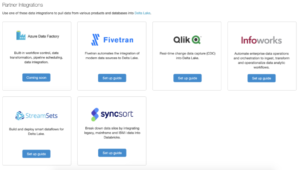

Um dieses Problem zu lösen, haben wurde das Data Ingestion Network gestartet. Es handelt sich hier um eine einfache und automatisierte Möglichkeit, das Lakehouse mit Hunderten von Datenquellen aus Delta Lake zu bestücken. Es gibt hierfür ein weitreichendes Partnernetzwerk – Fivetran, Qlik, Infoworks, StreamSets und Syncsort.

Diese Integrationen in Data Ingest bieten Hunderte von Anwendungs-, Datenbank-, Mainframe-, Dateisystem- und Großdatensystem-Konnektoren und ermöglichen die Automatisierung, um diese uneinheitlichen Daten schnell und zuverlässig in ein offenes, skalierbares Lakehouse auf Databricks zu verschieben. Unternehmen, die Azure Databricks verwenden, profitieren bereits von der nativen Integration mit Azure Data Factory, um Daten aus vielen Quellen einzulesen. Unternehmen profitieren von folgenden Eigenschaften:

- Automatisierte Datenbewegung in Echtzeit: Der Ingest-Prozess ist für die Erfassung von Änderungsdaten (CDC) optimiert und ermöglicht eine einfache Automatisierung zum Laden neuer oder aktualisierter Datensätze in Delta Lake. Die Data Engineers müssen nicht länger Zeit für die Entwicklung dieser komplexen Logik aufwenden oder die Datensätze jedes Mal manuell verarbeiten. Die Daten in Delta Lake können automatisch mit Änderungen synchronisiert und auf dem neuesten Stand gehalten werden.

- Sofortige einsatzbereite Konnektoren: Data Engineers, Data Scientists und Data Analytics haben über das Data Ingest Network von Partnern Zugang zu sofort einsatzbereiten Konnektoren für SaaS-Anwendungen wie Salesforce, Marketo, Google Analytics und Datenbanken wie Oracle, MySQL und Teradata sowie für Dateisysteme, Mainframes und viele andere. Sie erleichtern die Einrichtung, Konfiguration und Wartung der Datenverbindungen zu Hunderten von verschiedenen Quellen.

- Zuverlässigkeit der Daten: Die Dateneingabe in Delta Lake unterstützt ACID-Transaktionen, die die Daten zur Abfrage und Analyse bereit machen. Dadurch werden mehr Unternehmensdaten für Business Intelligence-, Berichts-, Data Science- und maschinelle Lernanwendungen verfügbar, um bessere Entscheidungen und Geschäftsergebnisse zu erzielen.

Einrichtung der Dateneingabe in nur drei Schritten

Anwender können die Integrationseinrichtung des Data Ingestion Network von Partnern über die Databricks Partner Gallery aufrufen und darauf zugreifen.

Schritt 1: Partner-Galerie: Sie müssen zum Menü Partner-Integrationen navigieren, um das Data Ingestion Network der Partner zu sehen. Dies wird Partner-Galerie genannt. Danach gibt es kurze Anleitungen zur Implementierung.

Schritt 2: Einrichten von Datenbanken: Richten Sie als nächstes den Arbeitsbereich ein, um Partnerintegrationen zu ermöglichen und Daten in Delta Lake zu integrieren.

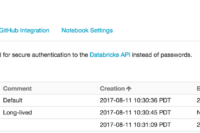

Nun muss ein Databricks-Token erstellt werden, das für die Authentifizierung durch das Partnerprodukt verwendet wird.

Nun muss von der Cluster-Seite Databricks die JDBC/ODBC-URL kopiert werden.

Schritt 3: Auswahl der Datenquellen: Nun müssen mit dem Partnerprodukt die Datenquellen ausgewählt werden, aus denen die Daten bezogen werden sollen und Databricks sollte als Ziel ausgewählt werden. Nun müssen das Token und die JDBC-Informationen aus Schritt 2 eingegeben und ein Auftrag eingerichtet werden, der dann Daten aus der Datenquelle abruft und im Delta-Lake-Format in Databricks schiebt.

Damit befinden sich die Daten befinden in Delta Lake, bereit zur Abfrage und Analyse.

Datenquellen-Ökosystem zur Bewältigung des Datenverzehrs

Das Data Ingestion Network ist ein gemanagtes Angebot, das es Datenteams ermöglicht, Daten aus Hunderten von Datenquellen zu kopieren und zu synchronisieren, wobei automatische Lade- und Aktualisierungsfunktionen zum Einsatz kommen. Fivetran, Qlik, Infoworks, StreamSets und Syncsort sind heute verfügbar, zusammen mit Azure Data Factory, die bereits eine native Integration für Azure Databricks-Kunden zur Aufnahme von Daten aus vielen Quellen bietet. Diese Partner ermöglichen den Zugang zu einer umfangreichen Sammlung von Datenquellen, die sowohl Cloud-basiert als auch vor Ort verfügbar sind.

Mit dem Data Ingestion Network sollte ein Ökosystem des Datenzugriffs aufgebaut werden, der es Kunden ermöglicht, das Potenzial der Kombination großer Daten und Daten aus Cloud-basierten Anwendungen, Datenbanken, Großrechnern und Dateisystemen zu nutzen. Durch die Vereinfachung des Dateneingabeprozesses im Vergleich zu herkömmlichem ETL haben Kunden die Möglichkeit, Komplexität und Wartungskosten gleichermaßen zu reduzieren. Diese beiden Faktoren sind typischerweise mit dem Zusammenführen von Daten aus vielen verschiedenen Quellen verbunden. Letztlich beschleunigt das Netzwerk den Weg zur Maximierung des Geschäftswerts von Daten in BI-, Berichts- und maschinellen Lernanwendungen.

Bharath Gowda ist VP of Product Marketing bei Databricks.