Abschätzung der Potenziale von Big Data Daten sind der neue Rohstoff

10. November 2015

Die meisten Unternehmen verfügen über sehr vielfältige Daten. Dieser Schatz bleibt in der Regel ungenutzt: Die meisten schöpfen das volle Potenzial ihrer Daten nicht aus – und bleiben damit weit hinter ihren Möglichkeiten. Die zusätzliche Integration von externen Datenquellen erlaubt es, moderne Analysemethoden zu optimieren – ein Plädoyer für den Einsatz moderner Business-Intelligence-Methoden.

Datenflut

2,8 Millionen Amazon-Bestellungen täglich, 3,6 Milliarden Paypal-Transaktionen im Jahr 2014: Die zunehmende Digitalisierung des Alltags erzeugt eine wahre Datenflut auf Consumer- wie auf Business-Seite. Das Internet der Dinge (Internet of Things, IoT) und Industrie 4.0 befeuern diese Entwicklung zusätzlich. Immer mehr Geräte liefern immer hochwertigere Daten in riesigen Mengen – von Maschinen- und Sensordaten über Geo- und Telematik-Daten bis zu Healthcare- und Gebäudedaten.

Die zunehmende Vernetzung von Geräten und Anwendungen führt zu einer Datenexplosion. Experten gehen davon aus, dass sich bis 2020 die Datenquellen und -mengen um den Faktor 10 vervielfacht haben. Mehr als 40 Prozent aller IoT-Daten werden dann in der Cloud liegen – bereit zur eingehenden Analyse.

Aus Sicht der Unternehmen bieten diese Datenmengen fast unermessliche Chancen. Business Intelligence und Data Science sind hier die Schlagworte: Moderne Technologien, Methoden und Algorithmen erlauben flexible Analysen umfangreicher Daten in Echtzeit. Die Steuerung von Geschäftsprozessen und die Grundlagen unternehmerische Entscheidungen basieren zunehmend auf diesen Analysen. Effizienz- und Umsatzsteigerung, zum Beispiel durch eine verbesserte Kundenansprache, stehen dabei oft im Vordergrund. Darüber hinaus besteht für viele Unternehmen ein großes Potential der Risikominimierung durch geeignete Analysen.

Als strategisches Thema ist BI in den Unternehmen allerdings bisher nur selten verankert; dabei werden sich künftig, angesichts sich immer schneller ändernden Märkte, kürzerer Produktzyklen und bröckelnder Kundenloyalitäten, weitestgehend nur auf diesem Wege fundierte Entscheidungen treffen lassen. Innovative Geschäftsmodelle setzen die schnelle Verarbeitung von großen Datenbeständen unterschiedlicher Herkunft inzwischen fast zwingend voraus.

Varianz in Branchen

Innerhalb der Branchen zeichnet sich derweil ein recht heterogenes Bild: Gerade beim Thema BI gibt es sehr unterschiedliche Sichtweisen, die nicht zuletzt von den spezifischen Bedingungen der jeweiligen Branchen abhängen; auch sind die Branchen in der Umsetzung von modernen Analyse- und BI-Konzepten unterschiedlich weit vorangekommen. Entscheidungen auf Basis solcher Verfahren werden bisher vor allem bei Versicherungen, in der Automobilindustrie, im Handel und in der Logistik getroffen. Eine von der Wirtschaftsprüfungsgesellschaft KPMG und dem Digitalverband Bitkom durchgeführte Studie ("Mit Daten Werte schaffen, Report 2015", befragt wurden insgesamt 706 Unternehmen) hat gezeigt, dass die einzelnen Branchen nicht nur teilweise weit auseinanderliegen, sondern mitunter auch ganz verschiedene Ansätze verfolgen.

Diese Studie zeigt deutlich: Eine Vereinheitlichung des Themas BI wird es niemals geben, weil die sachlichen Voraussetzungen der besonderen Anwendungsszenarien grundsätzlich eine große Rolle spielen. Allerdings wird klar: Potenzial ist überall vorhanden und je mehr Unternehmen im Wettbewerb stehen, desto stärker bietet ihnen BI die Möglichkeit, sich darin besser zu positionieren.

Die Studie von KPMG und Bitkom weist darauf hin, dass mehr als die Hälfte der befragten Unternehmen das Datenmanagement von der Datensammlung über das Design bis zur Aufbereitung an externe Dienstleister wie Nexinto übergeben hat, ein Viertel der Unternehmen sogar vollständig. Gerade das Thema BI eignet sich dafür, weil Dienstleister hier spezifisches Know-how und Erfahrung einbringen können, die Unternehmen aller Branchen erst noch erwerben müssen.

Die Tendenz verstärkt Dienstleister einzusetzen, hat darüber hinaus noch einen zweiten Grund: Mit der zunehmenden Datenflut ändern sich die Bedingungen für BI. Traditionelles BI, das auf Data-Warehouse-Systemen basiert, ist zur Beantwortung flexibler Fragestellungen heute nicht mehr ausreichend. Umfang, Varianz und Geschwindigkeit der gesammelten Daten erfordern für das systematische Sammeln und Aufbereiten geschäftskritischer Daten in Echtzeit den Einsatz neuer Technologien, etwa von Hadoop oder Massiv Parallel Processing. Fortschrittliche Lösungen bedienen sich dabei auch für Echtzeit-Analysen heute bevorzugt der Cloud. Und gerade hier verfügen Dienstleister häufig über einen wesentlichen Technologievorsprung in Know-how und Equipment.

Lösungskompetenz bestimmt Qualität

Die verschiedenen Arten und Quellen von Daten zu erfassen und zu verstehen, ist die Basis, um effektive und effiziente Analysen zu entwickeln. Mehrwerte lassen sich nur erzeugen, wenn das Zusammenspiel aus technologischer und analytischer Kompetenz stimmt. Genau an dieser Stelle kommt es auf die Expertise des Dienstleisters an.

Grundsätzlich lassen sich vier Bereiche mit wesentlichen Herausforderungen bei der Umsetzung operativer Big-Data-Lösungen ausmachen. Die Flexibilität und Lösungskompetenz des jeweiligen Dienstleisters bilden hier eindeutige Indikatoren seiner Qualität.

• Die Konzeption: Pauschallösungen kommen hier kaum in Frage. Das ist vor allem den sehr unterschiedlichen Szenarien und Use Cases innerhalb der Branchen geschuldet. Kompetente Berater werden also in jedem Fall einen individualisierten Ansatz verfolgen. Im Mittelpunkt steht dabei eine übergeordnete Datenanalyse-Strategie. Es gilt die Potenziale verschiedener Daten zu erkennen und relevante Anwendungsfelder für Analysen zu identifizieren.

• Der Betrieb: Kein Dienstleister, der etwas auf sich hält, wird um den Einsatz fortgeschrittener, spezialisierter Technologien umhinkommen. Dabei geht es nicht nur um die Bereitstellung entsprechender technologischer Plattformen für e-Commerce, IoT und Industrie 4.0. Auf Grund der kurzen Innovationszyklen moderner Technologien steht der zuverlässige Betrieb dieser Big-Data-Infrastrukturen zunehmend im Vordergrund. Datenanalysen erstrecken sich mittlerweile über alle Bereichen und Abteilungen eines Unternehmens und darüber hinaus im Zusammenspiel mit Dienstleistern. Verlässlichkeit und Verfügbarkeit werden damit zu wichtigen Faktoren, die vollautomatisierte Betriebsführungsprozesse inklusive Monitoring und ein an DevOps und ITIL ausgerichtetes Betriebsmodell erfordern.

• Compliance und Sicherheit: Wer externe Daten auswerten möchte, sieht sich schnell mit den äußerst strengen Vorgaben der deutschen Gesetzgebung konfrontiert. Datensicherheit und Datenschutz sind in diesem Kontext ein äußerst sensibles Thema. Nachlässigkeit oder Missbrauch können schnell sehr teuer werden. Umso wichtiger, dass der Dienstleister tiefe Expertise besitzt, glaubwürdig belegt durch entsprechende Zertifizierungen. Auf technischer Seite spielt die Echtzeiterkennung von Anomalien und Sicherheitsbedrohungen eine bedeutende Rolle. Auf diese Weise sind Reaktionen zur sinnvollen Optimierung der Verfügbarkeit von Kunden-Plattformen und zur Minimierung negativer finanzieller Auswirkungen erst realisierbar.

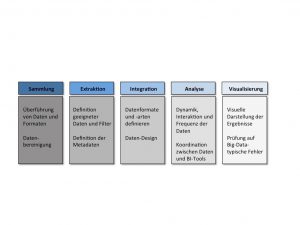

• Big-Data-Expertise: Logischerweise sollte der Dienstleister den gesamten Prozess der Big-Data-Analyse begleiten und unterstützen können, angefangen bei der Datensammlung über das Design bis zur eigentlichen Analyse und Visualisierung. Dazu gehört es beispielsweise, die Bereitstellung von Schnittstellen zur Erhebung kundennaher Rohdaten aus Hosting und Logistikkette zentral verfügbar und auswertbar zu machen. Ein wesentlicher Punkt bei der Datenanalyse ist zudem die Visualisierung unterschiedlichster Datenklassen, etwa anhand von Dashboards für Performance-relevante KPIs oder wichtige systemnahe Metriken.

Egal, ob mit Dienstleister oder ohne: Die Studie von KPMG und Bitkom attestiert allen Branchen enormes Entwicklungspotenzial in Sachen BI. Dabei ist die richtige Strategie für den Umgang mit Daten entscheidend, um Mehrwerte zu schaffen. Unternehmen sollten mögliche Anwendungsfelder klar eingrenzen und sich auf einzelne Bereiche konzentrieren, die den größten Nutzen versprechen.

Diethelm Siebuhr

ist CEO der Nexinto Holding in Hamburg und

Martin Becker

Ist Senior Solutions Consultant bei Nexinto.