Hadoop: Schlüsseltechnologie für effiziente Big-Data-Analysen So wollen Unternehmen Hadoop einsetzen

23. Juli 2015

Eine Schlüsseltechnologie, durch die effiziente Big-Data-Analysen überhaupt erst möglich werden, ist Hadoop. Das freie Java-Framework mit seinen verschiedenen Komponenten ist allerdings eine relativ neue Technologie, mit der viele Unternehmen noch keine Erfahrung haben.

Eine aktuelle BARC-Studie hat nun erste Informationen hinsichtlich der Erwartungen, Einsatzfelder und Stolpersteine in den Unternehmen gesammelt.

Nutzen noch unklar

Mit 261 Teilnehmern aus der DACH-Region und einer breit gefächerten Branchenverteilung gehört die Studie „Hadoop als Wegbereiter für Analytics“ des Business Application Research Center (BARC) zu einer der ersten Untersuchungen, die sich speziell Hadoop widmen. 78 Prozent der Befragten (171 Unternehmen) setzen danach Hadoop bereits ein oder planen dies bzw. können sich zumindest den Einsatz von Hadoop vorstellen.

Hadoop wird aktuell vor allem durch die IT getrieben (52 Prozent) und soll vorrangig technische Themen adressieren. Häufigstes Ziel ist die Nutzung als Plattform für eine einfachere Verwaltung großer Datenvolumina (68 Prozent) sowie semi-/unstrukturierter Datenquellen (61 Prozent). An dritter Stelle folgen dann fachlich-analytische Anforderungen wie eine größere Flexibilität bei der Datenanalyse (44 Prozent) und nach erweiterten Analysefunktionen (42 Prozent), die Hadoop ermöglichen soll. Seltener als erwartet wollen Unternehmen hingegen durch das Framework ihre Kosten für die analytische Infrastruktur senken (37 Prozent).

Experimentierphase

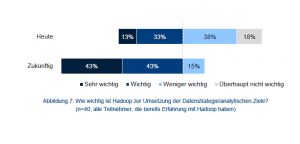

Die Hadoop-Nutzung befindet sich insgesamt noch in der Klärungs- und Experimentierphase. Bei der Bewertung der Relevanz des Themas zeigt sich ein gemischtes Bild. Generell sehen zirka drei Viertel der Unternehmen Hadoop als ein weniger bzw. überhaupt nicht wichtiges Thema an. Dies lässt den Schluss zu, dass der Mehrwert von Big-Data-Initiativen und Analytics respektive der Einsatz von Hadoop in vielen Unternehmen noch nicht identifiziert werden konnten oder nicht vorhanden sind. Letzteres scheint vor dem Hintergrund der Digitalisierungskräfte unwahrscheinlich. Bei je-dem vierten Unternehmen nimmt Hadoop dagegen mindestens einen wichtigen Stellenwert ein. Das ist ein durchaus beachtlicher Wert für ein solch junges Thema.

Ein Blick auf den Status quo von Hadoop-Initiativen in den Unternehmen bestätigt die größtenteils bestehende Unsicherheit gegenüber der programmiernahen Technologie. Demnach machen sich 29 Prozent der Befragten mit dem Thema Hadoop derzeit vertraut, 49 Prozent wissen oder vermuten um den Nutzen, adressieren das Thema aber noch nicht. Dass nur 21 Prozent der Befragten nichts mit Hadoop anfangen können, kann so gedeutet werden, dass Hadoop als Technologie und Begriff im Markt für Analytics angekommen ist.

Fehlende Relevanz/Priorität (61 Prozent) aber auch fehlendes Wissen sind entscheidende Gründe, warum für knapp jedes fünfte Unternehmen eine Hadoop-Initiative nicht denkbar ist. Die hohen Werte für die Antwortoptionen „Fehlende überzeugende Einsatzszenarien“, „Thema im Unternehmen unbekannt“ und „Kein Vorteil/Nutzen erkennbar“ lassen sich allesamt auf mangelndes Wissen über Hadoop zurückführen. Hier bedarf es schlicht und ergreifend mehr und besserer Aufklärung.

Erste Anwendungsbeispiele

Dabei finden sich durchaus schon erste produktive Systeme bzw. Unternehmen, die den Hadoop-Einsatz konkret vorbereiten und dabei ein durchaus breites Spektrum abbilden. Unter diesen Vorreitern ist die Nutzung von Hadoop als Ablaufumgebung für fortgeschrittene Analyse/Exploration aktuell die häufigste Anwendung (24 Prozent). Dies entspricht dem Wunsch vieler Fachbereiche nach einer eigenen, neben dem Data Warehouse existierenden Explorationsumgebung. Ein weiteres wichtiges Einsatzgebiet betrifft allgemein die erweiterte Nutzung von Daten – sei es als Staging/Landing Area oder zur Datenintegration polystrukturierter Daten (je 20 Prozent). Insgesamt belegt die BARC-Studie, dass fehlendes technisches (68 Prozent) und fachliches Know-how (65 Prozent) aktuell die bei weitem häufigsten Probleme sind, über die Unternehmen klagen um das komplexe und technische Hadoop letztendlich nutzbar machen zu können. Hier werden die fehlende Marktreife und der Mangel an Aufklärung beim Thema Hadoop deutlich.

„Unternehmen müssen dringend einen Weg finden, diese Wissenslücke zu schließen, denn ohne entsprechendes Know-how ist an den produktiven Einsatz einer wenn auch noch so vorteilhaften Technologie nicht zu denken“, betont Timm Grosser, Senior Analyst Datenmanagement und Co-Autor der Studie. Auch die dritthäufigste Antwort „Fehlende überzeugende Einsatzszenarien“ (43 Prozent) deute auf fehlendes Wissens über Hadoop im Besonderen und Big Data im Allgemeinen hin. Im Gegensatz zu klar strukturierten BI-Projekten sind Big-Data- und Hadoop-Initiativen sehr viel stärker explorativer Natur. Big-Data- und Hadoop-Projekte sollen durch ihren explorativen Charakter gerade dazu beitragen, konkrete Einsatzmöglichkeiten, Zusammenhänge und Erkenntnisse aufzudecken.

An der Anwenderbefragung „Hadoop als Wegbereiter für Analytics“ beteiligten sich 261 Teilnehmer. Es wurde dabei eine breit gefächerte Branchenverteilung der Studienteilnehmer erreicht. Besonders häufig ist der Dienstleistungssektor (23 Prozent), die Industrie (22 Prozent), die IT-Branche (17 Prozent) und der Handel (12 Prozent) vertreten. Die unabhängig erstellte Studie ist dank eines Sponsoring des Softwareherstellers SAS kostenfrei erhältlich.

Rainer Huttenloher

Hier geht es zur Studie